가끔 퇴근길에 서점에 들르곤 한다. 직업이 직업이라 그런진 몰라도 항상 IT코너에 머물러 어떤 새로운 책들이 출간되었나 보게 된다.

그러다보면 최근 유행하는 컨셉이나 아키텍쳐, 프로그래밍 언어나 개발방법론 등에 대해 트렌드가 뭔지 관찰하려고 안해도 자연히 접하게 되는 것 같다.

그 중 최근 유행처럼 사람들 입에 오르내리기도 하고 책으로 소개되기도 하는 개념들 중 MSA(Micro Service Architecture)라는 것이 있다.

뭔가 하고 들여다보니 MSA 개념에서 다루고 있는 '독립적으로 수행되는 최소단위의 서비스' 그리고 그 서비스들의 집합으로서의 시스템과 시스템의 분할에 관한 관점 및 해석은 십수년전 주목받던 SOA(Service Oriented Architecture)가 지향하는 서비스를 구성하는 기능별 시스템의 분할과 크게 다르지 않다.

뭔가 하고 들여다보니 MSA 개념에서 다루고 있는 '독립적으로 수행되는 최소단위의 서비스' 그리고 그 서비스들의 집합으로서의 시스템과 시스템의 분할에 관한 관점 및 해석은 십수년전 주목받던 SOA(Service Oriented Architecture)가 지향하는 서비스를 구성하는 기능별 시스템의 분할과 크게 다르지 않다.

이 글은 MSA와 SOA가 얼마나 비슷한 사상으로 소개된 개념인지를 이야기하고자 함이 아니다. 예전에도 의미있게 다뤄졌고 지금도 의미있게 받아들여지는 이러한 개념들이 시스템의 관점에서 더 좁게는 DBMS라는 시스템 소프트웨어적 관점에서 어떻게 해석될 수 있는가를 간단하게 짚어보고자 함이다.

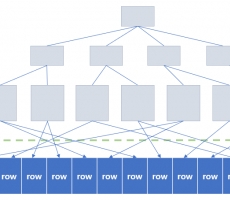

MSA의 개념이 제대로 구현되기 위해서는 시스템이 제공하는 서비스들간 그리고 서비스와 서비스의 수요자간의 추상화된 관계가 명확하게 정의되어야 하며 이는 분산시스템의 확장성측면에서 매우 중요한 고려사항이 된다. 매우 중요한 고려사항이 된다는 이야기는 해당 분산 시스템의 아키텍쳐를 결정하는 요소가 된다는 의미이다.

서두가 길었지만 '확장성'말고도 분산시스템의 아키텍쳐를 결정하는데 영향을 미치는 요소는 '성능(performance)', '사용성(usability)', '편의성(user convenience)', '모니터링의 용이성(monitoring)', '기능성(functionality)', '가용성(availability)' 등 여러가지가 있다.

예를들어 흔히 이중화라고 하는 replication의 경우 HA(High Availability)를 충족시키기 위한 아키텍쳐이다. RAID라는 용어를 들어보았을 것이다. data redundancy를 제공해 media(disk) 차원에서의 MTTF를 최소화하려는 아주 오래된 컨셉이다. HA라는 것은 시스템이 제공하는 서비스 총체적인 차원에서의 MTTF를 최소화하려는 redundant한 시스템 아키텍쳐이다.

이러한 목적으로 구현된 replication은 그 구현을 위한 기술요소가 분산인 것이지 분산시스템으로서 갖고 있는 목적 자체는 HA인 것이다. 시스템 소프트웨어 개발자들이 흔히 하는 실수는 HA를 목적으로 만들어진 replication을 갖고 다른 분산시스템 예를 들어 흔히 생각해볼 수 있는 cluster(active-active가 되는)도 만들고 cdc(changed data capture)도 만들고 sharding(단순한 table partitioning이 아니라 볼륨의 증감에 따라 re-sharding이 되는 sharding을 말한다)도 만들고 그럼 된다고 생각하는 것이다.

하지만 그런 안일한 생각이 수개월 혹은 수년의 개발기간을 거쳐 만든 분산 기능자체를 버그 덩어리 내지는 수년간 repository에서 숙성기간을 거치면서 수많은 개발자들에 의해 더럽혀지다가 결국엔 제대로 써보지도 못한채 방치되거나 버려지는 몹쓸 코드덩어리를 만들어낸다.

모두 분산을 위한 기술요소를 갖고 있음에는 틀림이 없다. 하지만 아키텍쳐는 해당 시스템의 목적에 따라 달라져야 한다. 그리고 가능한 기존 시스템에 안좋은 영향을 주지않도록 설계되어야 한다. 위에 열거한 모든 요소들을 하나의 시스템 소프트웨어에서 만족시키는 아키텍쳐를 구현하기란 쉽지 않은 일이다.

그래서 최근의 시스템 아키텍팅의 트렌드는 단일 목적에 특화된 여러 시스템들의 정합성을 고려하여 커다란 시스템으로 엮는 것이다. 그리고 그러한 트렌드에 맞춰 손쉽게 오케스트레이션을 할 수 있도록 해주는 쿠버네티스같은 플랫폼들이 인기를 끌고 있다.

하지만 하나의 시스템이 만약 해당 서비스에 필요한 대부분의 요소들을 모두 제공한다면? 굳이 여러 시스템을 엮어 쓸 이유가 없다. 여러 시스템을 엮는다는 것은 그만큼의 비용(데이터 처리 비용)이 증가한다. 데이터가 시스템에 들어와 사용자에게 전달될 때까지 지나치는 경로가 길어질수록 비용은 증가한다. cpu core를 예로 들어보자. data와 instruction이 전달되는 경로를 bus라고 한다. 그 bus의 길이를 보다 짧게 하려고 cache도 두고 locality를 증가시키기 위한 무수한 노력을 한다. 그러다가 하나로 안되니 두개를 붙이고 4개를 붙이고 6개를 붙이고 core수를 늘리다가 결국 특수 목적의 연산유닛이었던 GPU도 붙이고 그런다. GPU를 그냥 옆에 쓸수있게 붙여놓기만 했던 시절에는 GPU에서 처리한 데이터를 다시 cpu에서 받아 처리하는데 필요한 데이터 복제 (메모리간)비용이 상당했고 그걸 처리하기 위한 고민과 기술들이 필요했다. 그러나 지금은 하나의 칩에서 대부분의 작업을 거뜬히 해낼 수 있게 되었다.

분산시스템도 마찬가지다. 10년전만 해도 하둡하둡하면서 하둡만이 살길인양 분산시스템을 구축하는 프로젝트에서는 너도나도 하둡개발자를 찾았지만 이젠 하둡도 쓸까말까를 고민한다.

하나의 시스템 혹은 플랫폼이 등장할 때마다 그것을 이용한 보다 나은 조합들이 나오고 정말 최고의 조합이어서든 자본에 의해서든 적어도 2~3년은 이쪽 업계 사람들의 입에 오르내릴만한 조합들이 나오곤 한다. 그러나 분산 시스템을 이해하는 개발자 관점에서 아쉽게 느껴지는 것들이 참 많다. 그중 하나는 브랜드파워 내지는 거대자본의 투입(대대적인 글로벌 컨퍼런스의 개최라든지 프로모션과 같은 것들)이 가능한 시장의 leading company에 의해 그들이 제공하는 조합 내지는 그들의 플랫폼, 그들의 제품을 사용하지 않으면 뒤떨어질 것 같은 인식이 확산되는 경향이 최근들어 빈번하게 발생하고 있다는 것이다. 한번 이러한 인식이 형성되기 시작하면 다른 조합은 이미 고려대상이 아니게 될 뿐 아니라 서비스 차원에서 시스템을 아키텍팅하는 엔지니어들 조차 소위 '대세' 시스템 아키텍쳐를 공부하고 모방하며 뒤질세라 자신의 세미나를 발표하면서 시스템의 획일화에 기여한다.

그러나 사실은 아니 진실은 '누구나 그렇게 해야만 할 것같은 그런 분위기'가 아니다. 위에 열거한 서로 다른 요소들이 어떤 우선순위와 가중치를 갖고 시스템에서 제공되어야 하는가에 대한 고려가 우선되어야 한다. 조합 가능한 서로 다른 시스템들의 가짓수가 늘어날수록 솔루션으로서의 분산시스템 아키텍쳐 구성의 가짓수또한 증가한다.

그런 와중에도 대부분의 분산 아키텍쳐에 중요한 고려사항으로써 항상 포함되는 건 데이터베이스이고 데이터베이스를 관리하는 시스템이다. 스트림처리를 통해 저장할 필요없이 사용 후 바로 제거되어도 되는 데이터들을 제외한 모든 데이터들은 데이터베이스를 한번씩은 거치기 마련이기 때문이다.

DBMS는 이러한 데이터베이스를 관리하기 위한 시스템이고 많은 진화를 거듭하면서 보다 완전한 시스템이 되어가는 중이다. 아직도 가야할 길이 많지만 적어도 30년전 oracle을 생각하면 지금의 oracle은 거의 천상계가 아닌가.

혹자는 '빅데이터 시대'가 도래하고 부터는 DBMS는 퇴물이고 이제 곧 그 자리를 다른 시스템들이 대체하게 될거라는 말들을 하곤 한다. 미안한 말이지만 당신 앞에서 이런 이야기를 던지는 사람이 시스템 컨설턴트라면 그들이 제안하는 시스템 아키텍쳐를 신뢰하지 말라고 충고하고 싶다.

'빅데이터'는 이를 처리하는 단일 시스템에 보다 효율적인 처리를 위해 새로운 처리방식 혹은 새로운 데이터 모델링을 요구하거나 해당 시스템의 처리량을 넘어선 데이터 공급량으로 인해 보다 효율적인 처리방식을 고려하도록 하는 변화된 데이터환경 자체를 비즈니스적으로 표현한 말이고 시스템적 관점에서 '사실상의 대용량(때때로 실시간의 처리가 요구되는)'을 달리 표현한 말에 지나지 않는다. ('빅데이터'라는 용어가 확산되기 시작했던 2010년대 초반 필자가 국내학회지에 기고했던 글을 참조해보면 이 문장의 의미가 더 잘 이해해될 수도 있다. 참조 문서: 데이터 환경의 변화와 분산 데이터베이스 시스템)

그러나 사실 DBMS는 사실상의 대용량 데이터를 처리하기 위한 시스템이다.

DBMS가 오래전부터 맞닥드린 데이터 환경이 바로 '대용량'이고 이 '대용량'의 기준은 점점 높아져 왔을 뿐이다. 따라서 DBMS의 고민은 다름이 아니라 애초부터 대용량이었다. 1970년대 등장한 RDBMS의 시조새격인 ingres 도 이 대용량(당시의)을 처리하기 위해 만들어졌다.

대용량 데이터의 처리는 DBMS의 숙명과도 같은 것이다.

'대용량'이라는 키워드와 더불어 DBMS가 항상 안고 가는 숙제가 하나 있다. 바로 '실시간'이다.

'실시간'은 시스템, 즉 DBMS의 성능과 밀접한 관련이 있다. 뭘 실시간으로 제공하느냐에 따라 아키텍쳐는 달라진다. 저장관점에서의 쓰기연산이 실시간으로 이루어져야 하는지, 아니면 검색관점에서의 읽기연산이 실시간으로 이루어져야 하는지, 아니면 읽고쓰는 대부분의 연산에서 실시간이 보장되어야 하는지, 서비스에 따라 실시간의 허용범위는 어느정도인지 등 서비스 환경에 따라 다양하다.

DBMS는 이러한 저장 데이터베이스에 대해 수행되는 읽고쓰기 연산의 결과를 상위 시스템 혹은 클라이언트로 전달하는 주체로써 실시간성을 중요하게 고려한다.

이렇듯 DBMS는 실시간과 이전에 설명한 대용량에 대한 처리를 고민하면서 분산 DBMS로 발전한다.

하나의 통합 서비스에서 처리해야 하는 데이터의 양이 DBMS가 처리할 수 있는 수준범위 내에 있다면 다른 시스템은 필요가 없다. 그저 데이터를 받아 DBMS로 전달하는 일만 하면 된다. 그러나 그 데이터들을 DBMS가 다 처리를 못한다. 그래서 중간에 여러 DBMS들에 실시간으로 데이터들을 분산시켜 던져주는 미들웨어 시스템을 두고 DBMS마다 처리하는 속도가 달라 처리된 시점에 필요한 놈이 가져가게 하기 위한 message queue를 둔다. message큐가 처리할 수 있는 용량에도 한계가 있고 가용 저장장치에도 한계가 있기 때문에 저장용 cache를 따로 둔다. 그리고 데이터를 소비한 후 visualization을 따로 해줘야 하는 경우 처리를 위한 시스템을 별도로 엮기도 한다. 이건 하나의 예에 불과하다.

결국 쉽게 말하면 DBMS가 못따라가는 데이터처리를 다른 시스템들을 붙여 어떻게든 그래도 효율적으로 처리해보려는 것이다.

그래서 DBMS는 나날이 커져만 가는 대용량에 대응할 수 있는 시스템으로 진화해야 한다. '나날이 커져만가는 대용량에 대응'하기 위한 요소가 바로 '확장성'이다. 하나의 처리 노드에서 감당할 수준을 넘어선 데이터량 때문이다. 이러한 확장성을 갖춘 DBMS는 분산 feature를 장착한 분산 DBMS라고 할 수 있다. 하지만 아직 다양한 서비스 환경에서 실시간 처리에 대한 요구를 만족시켜주는 단일 분산 DBMS는 찾아보기 힘들다. 분산 DBMS로 가야할 길은 아직 멀고 험하다. 어쩌면 일개 시스템소프트웨어 개발자에게는 영원히 끝이 보이지 않는 길일 확률이 아주 높다. 그럼에도 불구하고 DBMS의 숙명과도 같은 '대용량의 데이터를 실시간으로 처리'하기 위해 DBMS는 진화하고 또 진화해간다.

시스템 소프트웨어 불모지인 대한민국의 국산 DBMS로서 이미 그 효용성을 입증한 큐브리드가 그렇게 진화해가길 진심으로 바란다.