Docker, Kubernetes 환경에서 CUBRID 컨테이너 서비스 해보기

최근에 여러 기업에서 Docker, Kubernetes를 사용하여 컨테이너로 서비스 하는 사레들을 많이 보았습니다. CUBRID도 컨테이너로 만들어서 Docker, Kubernetes 환경에서 서비스 해보려고 합니다.

Docker는 '가장 빨리 만나는 Docker: 클라우드 플랫폼 어디서나 빠르게 배포하고 실행할 수 있는 리눅스 기반 경량화 컨테이너'라는 책으로 처음 접하였습니다. 책을 구매해서 보는 것을 권장드리지만 'http://pyrasis.com/docker.html' 페이지에서 책의 내용을 공개하고 있습니다. 책이 너무 길다면 Slideshare, 'https://www.slideshare.net/pyrasis/docker-fordummies-44424016' 페이지에서 슬라이드로 요약된 내용을 볼 수 있습니다.

Docker는 Docker라는 회사에서 OS에서 제공하는 가상화 기술을 사용하여 만든 오픈소스 Container 프로젝트의 결과물입니다. 컨테이너는 호스트에 게스트 환경을 구성한다는 점에서는 가상머신과 비슷하지만 OS를 별도로 설치해 줄 필요가 없고, 호스트와 동일한 성능을 낼 수 있다는 장점이 있습니다. 이외에도 여러가지 장점이 많지만 가장 큰 장점은 배포가 쉽다는 점이라고 생각합니다. 이 장점을 잘 활용하는 것이 Kubernetes 입니다.

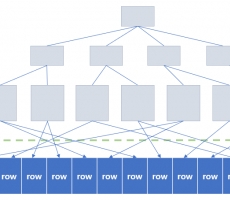

Kubernetes는 Google이 컨테이너의 배포를 자동화하고 관리하기 위해서 만든 오픈소스 컨테이너 오케스트레이션 도구입니다. 여러 대의 호스트에 컨테이너를 배포하고 관리하는 일은 호스트들의 리소스와 컨테이너를 포함하여 네트워크 연결 문제 등을 고려해야 하기 때문에 쉽지 않지만 Kubernetes가 이를 대신 해줍니다.

Docker와 Kubernetes에 대한 개념적인 내용과 장,단점은 앞서 소개했던 사이트처럼 이해하기 쉽게 잘 정리되어 있는 글들이 많이 있습니다. 이 글들과 중복하여 개념정리 하는 것보다 Docker, Kubernetes 환경을 구성하고 CUBRID를 컨테이너로 만들어서 서비스를 해봤던 과정들에 대해서 자세히 다뤄보려고 합니다.

목차

1. 노드 구성

2. Docker 설치

3. 방화벽 설정

4. Kubernetes 설치

5. pod network add-on 설치

6. kubeadm join

7. Kubernetes Dashboard 설치

8. CUBRID 컨테이너 이미지 생성

9. Docker Hub에 CUBRID 컨테이너 이미지 올리기

10. Kubernetes 환경에 CUBRID 컨테이너 배포

1. 노드 구성

Kubernetes를 활용하여 컨테이너를 배포하고 서비스 하는 부분까지 다루려면 최소 2개(Master, Worker)의 노드가 필요합니다. 저는 각각 다른 노드에서 Container가 생성되는 것을 확인하기 위해서 3개의 노드로 테스트 하였습니다. 각 노드들의 OS는 'https://www.centos.org/download/' 페이지에서 CentOS 7.5.1804버전 ISO 파일을 다운로드 받아서 Minimal로 설치하였습니다.

1-1. Hostname 설정

# hostnamectl set-hostname master

# hostnamectl set-hostname worker1

# hostnamectl set-hostname worker2

1-2. /etc/hosts 설정

# cat << EOF >> /etc/hosts

192.168.37.131 master

192.168.37.132 worker1

192.168.37.133 worker2

EOF

2. Docker 설치

Kubernetes는 컨테이너의 배포를 자동화하고 관리만 할 뿐이고 실제 컨테이너 서비스를 하는 것은 Docker 입니다. 그래서 Kubernetes 설치 전에 Docker가 먼저 설치되어 있어야 합니다. Docker는 Community Edition(CE)을 설치했습니다. Docker CE에 대한 설치는 'https://docs.docker.com/install/linux/docker-ce/centos/' 페이지를 참고했습니다.

2-1. Docker 설치에 필요한 YUM Package 설치

YUM Repository를 추가할 때 사용하는 yum-config-manager 유틸리티가 포함되어 있는 yum-util 패키지와 devicemapper storage driver 사용에 필요한 device-mapper-persistent-data, lvm2 패키지 설치를 필요로 합니다.

# yum install -y yum-utils device-mapper-persistent-data lvm2

2-2. yum-config-manager 유틸리티를 사용해서 Docker CE Repository 추가

# yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo

2-3. Docker CE Repository에서 docker-ce 설치

kubernetes와 호환되기 위해서는 'https://kubernetes.io/docs/setup/release/notes/#external-dependencies' 참고하여 kubernetes가 지원하는 버전을 설치합니다.

# yum list docker-ce --showduplicates | sort -r

# yum install -y docker-ce-18.06.1.ce

2-4. OS 부팅 시 Docker 자동시작 설정

# systemctl enable docker

2-5. Docker 시작

# systemctl start docker

2-6. docker 명령어 확인

기본적으로 non-root 사용자는 docker 명령어를 실행할 수 없습니다. root 사용자 또는 sudo 권한이 있는 사용자 계정으로 로그인해서 docker 명령어를 실행해야 합니다.

# docker

2-7. Docker 그룹에 non-root 사용자 추가

root 사용자 또는 sudo 권한이 있는 사용자 계정으로 로그인하는 방법 외에 non-root 사용자가 docker 명령어를 실행하기 위해서는 Docker 그룹에 추가해야 합니다.

# usermod -aG docker your-user

참고. Docker 삭제

# yum remove -y docker \

docker-client \

docker-client-latest \

docker-common \

docker-latest \

docker-latest-logrotate \

docker-logrotate \

docker-selinux \

docker-engine-selinux \

docker-engine

# rm -rf /var/lib/docker

3. 방화벽 설정

Kubernetes 환경에서 사용하는 포트는 'https://kubernetes.io/docs/setup/independent/install-kubeadm/#check-required-ports' 페이지에서 확인 할 수 있습니다. 노드 종류(Master, Worker)에 따라서 사용하는 포트들이 다릅니다.

3-1. Master 노드

|

Protocol

|

Direction |

Port Range |

Purpose |

Userd By |

|

TCP |

Inbound |

6443 |

Kubernetes API server |

All |

|

TCP |

Inbound |

2379~2380 |

etcd server client API |

kube-apiserver, etcd |

|

TCP |

Inbound |

10250 |

Kubelet API |

Self, Control plane |

|

TCP |

Inbound |

10251 |

kube-scheduler |

Self |

|

TCP |

Inbound |

10252 |

kube-controller-manager |

Self |

# firewall-cmd --permanent --zone=public --add-port=6443/tcp

# firewall-cmd --permanent --zone=public --add-port=2379-2380/tcp

# firewall-cmd --permanent --zone=public --add-port=10250/tcp

# firewall-cmd --permanent --zone=public --add-port=10251/tcp

# firewall-cmd --permanent --zone=public --add-port=10252/tcp

# firewall-cmd --reload

3-2. Worker 노드

|

Protocol |

Direction |

Port Range |

Purpose |

Userd By |

|

TCP |

Inbound |

10250 |

Kubelet API |

Self, Control plane |

|

TCP |

Inbound |

30000-32767 |

NodePort Services |

All |

# firewall-cmd --permanent --zone=public --add-port=10250/tcp

# firewall-cmd --permanent --zone=public --add-port=30000-32767/tcp

# firewall-cmd --reload

3-3. pod network add-on (Master, Worker)

pod network add-on으로 설치할 Calico에서 사용하는 포트들도 열어주어야 합니다. Calico에서 사용하는 포트들은 'https://docs.projectcalico.org/v3.3/getting-started/kubernetes/requirements' 페이지에서 확인할 수 있습니다.

|

Configuration |

Host(s) |

Connection type |

Port/protocol |

|

Calico networking (BGP) |

All |

Bidirectional |

TCP 179 |

# firewall-cmd --permanent --zone=public --add-port=179/tcp

# firewall-cmd --reload

4. Kubernetes 설치

4-1. Kubernetes Repository 추가

# cat << EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://packages.cloud.google.com/yum/doc/yum-key.gpg https://packages.cloud.google.com/yum/doc/rpm-package-key.gpg

exclude=kube*

EOF

4-2. SELinux Permissive Mode로 설정

# setenforce 0

# sed -i 's/^SELINUX=enforcing$/SELINUX=permissive/' /etc/selinux/config

# sestatus

SELinux status: enabled

SELinuxfs mount: /sys/fs/selinux

SELinux root directory: /etc/selinux

Loaded policy name: targeted

Current mode: permissive

Mode from config file: permissive

Policy MLS status: enabled

Policy deny_unknown status: allowed

Max kernel policy version: 31

4-3. kubelet, kubeadm, kubectl 설치

- kubeadm : the command to bootstrap the cluster. (클러스터를 부트스트랩하는 명령)

- kubelet : the component that runs on all of the machines in your cluster and does things like starting pods and containers. (클러스터의 모든 시스템에서 Pod 및 Container를 시작하는 등의 작업을 수행하는 구성요소)

- kubectl : the command line util to talk to your cluster. (클러스터와 통신하는 명령 줄 유틸리티)

# yum install -y kubelet kubeadm kubectl --disableexcludes=kubernetes

4-4. OS 부팅 시 kubelet 자동시작 설정

# systemctl enable kubelet

4-5. kubelet 시작

# systemctl start kubelet

4-6. net.bridge.bridge-nf-call-iptables 설정

# cat << EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

# sysctl --system

4-7. swap off

Kubernetes는 Master, Worker 노드 모두 swap을 off 해야 합니다. swap이 off 되어 있지 않으면 kubeadm init 단계에서 "[ERROR Swap]: running with swap on is not supported. Please disable swap"와 같은 에러 메시지가 출력 됩니다.

# swapoff -a

# sed s/\\/dev\\/mapper\\/centos-swap/#\ \\/dev\\/mapper\\/centos-swap/g -i /etc/fstab

4-8. kubeadm init

초기화 작업은 'https://kubernetes.io/docs/setup/independent/create-cluster-kubeadm/' 페이지를 참고했습니다. pod network add-on의 종류에 따라서 --pod-network-cidr 설정 값을 다르게 해주어야 합니다. 여기서는 pod network add-on로 Calico를 사용해서 --pod-network-cidr 설정 값을 192.168.0.0/16으로 해야 하지만 가상머신 네트워크 대역인 192.168.37.0/24와 겹치기 때문에 172.16.0.0/16으로 변경하여 사용합니다.

# kubeadm init --pod-network-cidr=172.16.0.0/16 --apiserver-advertise-address=192.168.37.131

# mkdir -p $HOME/.kube

# cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

# chown $(id -u):$(id -g) $HOME/.kube/config

5. pod network add-on 설치

Kubernetes 환경에서 Pod들이 통신하려면 pod network add-on이 있어야 합니다. pod network add-on이 설치되기 전에는 CoreDNS가 시작되지 않습니다. 'kubeadm init' 이후에 'kubectl get pods -n kube-system' 명령어로 확인해보면 CoreDNS가 아직 시작되지 않은 상태를 확인할 수 있습니다. pod network와 호스트 네트워크가 겹칠 경우 문제가 발생할 수 있습니다. 그래서 앞서 'kubeadm init' 단계에서 가상머신 네트워크 대역과 겹치는 192.168.0.0/16 네트워크를 사용하지 않고 172.16.0.0/16으로 변경하여 사용했습니다.

kubeadm은 CNI(Container Network Interface) 기반 네트워크만 지원하며 kubenet은 지원하지 않습니다. CNI(Container Network Interface)는 CNCF(Cloud Native Computing Foundation)의 프로젝트 중 하나로 컨테이너 간의 네트워킹을 제어할 수 있는 플러그인을 만들기 위한 표준 인터페이스입니다. CNI(Container Network Interface)를 기반으로 만들어진 pod network add-on에는 여러 종류가 있고 'httpsx://kubernetes.io/docs/setup/independent/create-cluster-kubeadm/#pod-network' 페이지에서 각 pod network add-on 마다 설치법이 소개되어 있습니다. 여기서는 Calico를 사용하려고 합니다.

Calico 설치 방법은 위에 소개했던 페이지에서도 확인할 수 있지만 'https://docs.projectcalico.org/v3.3/getting-started/kubernetes/installation/calico' 페이지에도 소개되어 있습니다. Calico는 OSI(Open System Interconnection) 모델의 3계층(네트워크 계층)을 기반으로 합니다. BGP(Border Gateway Protocol)를 사용하여 노드 간 통신을 용이하게 하는 라우팅 테이블을 작성하고, Flannel 기반 네트워크 시스템보다 우수한 성능 및 네트워크 격리를 제공 할 수 있습니다.

5-1. Calico 설치

pod network add-on이 설치되어 있지 않은 상태에서는 CoreDNS가 아직 시작되지 않은 상태를 확인할 수 있습니다.

# kubectl get pods -n kube-system

NAME READY STATUS RESTARTS AGE

coredns-576cbf47c7-2fkrr 0/1 Pending 0 71s

coredns-576cbf47c7-bmns4 0/1 Pending 0 71s

etcd-master 1/1 Running 0 24s

kube-apiserver-master 1/1 Running 0 23s

kube-controller-manager-master 1/1 Running 0 15s

kube-proxy-xt66g 1/1 Running 0 71s

kube-scheduler-master 1/1 Running 0 40s

pod network add-on 설치는 Master 노드에서만 합니다. 'kubeadm init' 단계에서 --pod-network-cidr 설정 값을 172.16.0.0/16으로 변경하여 사용하기는 했지만 Calico YAML 파일에서도 값을 변경하여 설치해야 합니다.

# kubectl apply -f https://docs.projectcalico.org/v3.3/getting-started/kubernetes/installation/hosted/rbac-kdd.yaml

# sed s/192.168.0.0\\/16/172.16.0.0\\/16/g -i calico.yaml

# kubectl apply -f calico.yaml

pod network add-on를 설치한 이후에 CoreDNS가 정상적으로 시작된 상태를 확인할 수 있습니다.

# kubectl get pods -n kube-system

NAME READY STATUS RESTARTS AGE

calico-node-hdl24 2/2 Running 0 27s

coredns-576cbf47c7-2fkrr 1/1 Running 0 2m16s

coredns-576cbf47c7-bmns4 1/1 Running 0 2m16s

etcd-master 1/1 Running 0 89s

kube-apiserver-master 1/1 Running 0 88s

kube-controller-manager-master 1/1 Running 0 80s

kube-proxy-xt66g 1/1 Running 0 2m16s

kube-scheduler-master 1/1 Running 0 10

6. kubeadm join

Worker 노드가 되기 위해서는 'kubeadm join' 명령어를 실행해서 Master 노드에 등록해야 합니다. 'kubeadm join' 명령어 실행에 필요한 옵션들은 Master 노드에서 아래 명령어를 실행해서 확인할 수 있습니다.

# kubeadm token create --print-join-command

6-1. Worker 노드 등록

$ kubeadm join 192.168.37.131:6443 --token hcfumm.jerovbeueijtcflc --discovery-token-ca-cert-hash sha256:5e895759b68976638acc2f8c3ba6b8d0577a7d57d7e81d9c51e418cb90b2108c

7. Kubernetes Dashboard 설치

Dashboard 설치 방법은 'https://github.com/kubernetes/dashboard/wiki/Installation' 페이지에서 자세하게 확인할 수 있습니다. Kubernetes Dashboard 설치 방법에는 Recommended setup과 Alternative setup 등 두 가지가 있습니다. Alternative setup 설치 방법은 HTTPS를 사용하지 않고 HTTP를 사용하여 Dashboard에 접속하는 방법으로 권장하지 않습니다.

7-1. 인증서 생성

'kubectl proxy' 없이 Dashboard에 직접 접속하려면 유효한 인증서를 사용하여 보안 HTTPS 연결을 설정해야합니다.

# mkdir ~/certs

# cd ~/certs

# openssl genrsa -des3 -passout pass:x -out dashboard.pass.key 2048

# openssl rsa -passin pass:x -in dashboard.pass.key -out dashboard.key

# openssl req -new -key dashboard.key -out dashboard.csr

# openssl x509 -req -sha256 -days 365 -in dashboard.csr -signkey dashboard.key -out dashboard.crt

7-2. Recommended setup

# kubectl create secret generic kubernetes-dashboard-certs --from-file=$HOME/certs -n kube-system

7-3. Dashboard 서비스를 NodePort 방식으로 변경

Dashboard 서비스를 NodePort 방식으로 변경하면 'kubectl proxy' 없이 NodePort를 통해서 직접 접속할 수 있습니다.

# kubectl edit service kubernetes-dashboard -n kube-system

# Please edit the object below. Lines beginning with a '#' will be ignored,

# and an empty file will abort the edit. If an error occurs while saving this file will be

# reopened with the relevant failures.

#

apiVersion: v1

kind: Service

metadata:

annotations:

kubectl.kubernetes.io/last-applied-configuration: |

{"apiVersion":"v1","kind":"Service","metadata":{"annotations":{},"labels":{"k8s-app":"kubernetes-dashboard"},"name":"kubernetes-dashboard","namespace":"kube-system"},"spec":{"ports":[{"port":443,"targetPort":8443}],"selector":{"k8s-app":"kubernetes-dashboard"}}}

creationTimestamp: 2018-12-24T04:27:04Z

labels:

k8s-app: kubernetes-dashboard

name: kubernetes-dashboard

namespace: kube-system

resourceVersion: "1748"

selfLink: /api/v1/namespaces/kube-system/services/kubernetes-dashboard

uid: 2a4888ce-0734-11e9-9162-000c296423b3

spec:

clusterIP: 10.100.194.126

externalTrafficPolicy: Cluster

ports:

- nodePort: 31055

port: 443

protocol: TCP

targetPort: 8443

selector:

k8s-app: kubernetes-dashboard

sessionAffinity: None

type: NodePort

status:

loadBalancer: {}

7-4. Dashboard 접속정보 확인

# kubectl get service -n kube-system

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

calico-typha ClusterIP 10.106.255.36 <none> 5473/TCP 83m

kube-dns ClusterIP 10.96.0.10 <none> 53/UDP,53/TCP 84m

kubernetes-dashboard NodePort 10.107.122.34 <none> 443:31660/TCP 43m

7-5. Dashboard 계정 생성

# kubectl create serviceaccount cluster-admin-dashboard-sa

# kubectl create clusterrolebinding cluster-admin-dashboard-sa --clusterrole=cluster-admin --serviceaccount=default:cluster-admin-dashboard-sa

7-6. Dashboard 접속 시 필요한 계정 토큰 정보 확인

# kubectl get secret $(kubectl get serviceaccount cluster-admin-dashboard-sa -o jsonpath="{.secrets[0].name}") -o jsonpath="{.data.token}" | base64 --decode

eyJhbGciOiJSUzI1NiIsImtpZCI6IiJ9.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJkZWZhdWx0Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZWNyZXQubmFtZSI6ImNsdXN0ZXItYWRtaW4tZGFzaGJvYXJkLXNhLXRva2VuLTJoaHBoIiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZXJ2aWNlLWFjY291bnQubmFtZSI6ImNsdXN0ZXItYWRtaW4tZGFzaGJvYXJkLXNhIiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZXJ2aWNlLWFjY291bnQudWlkIjoiM2FmNzAwNzItMGMzZC0xMWU5LWE2NGUtMDAwYzI5NjQyM2IzIiwic3ViIjoic3lzdGVtOnNlcnZpY2VhY2NvdW50OmRlZmF1bHQ6Y2x1c3Rlci1hZG1pbi1kYXNoYm9hcmQtc2EifQ.d3PGfeMAbpUXPIDB-QLBbydrgTnkbv9Kf4WVGHmoGw0qW7MeQ2y8J0GmRe8IQDapo7rFMwMJRPHsBbPAlhwkrCLb_vCKYyFtdlbV66x7ZdBVRlhay-kKVsr2X-sO8qu6Vhv_PWrN8x0Maxhf1-sxB17--pmiH2Q6xcQp4T0SyNuJd-3pU6pttlVl7uh7ifypi7MXqz7rS7ZbuV3XpQkfNyhJrgAA_fyoiHbALymRW7j4NS0Xek5GbCrRM6owTXUYH5zkvTOZc0pSKSiFizr3g4JD7SY2V1DjgqGB5T4mIfZPdIHNoFZfKjhIgyRIsRXe0AMv3XUzcm_ta2sWBDBLPw

7-7. Dashboard 접속 확인

8. CUBRID 컨테이너 이미지 생성

8-1. Dockerfile

FROM centos:7

ENV CUBRID_VERSION 10.1.2

ENV CUBRID_BUILD_VERSION 10.1.2.7694-64632b2

RUN yum install -y epel-release; \

yum update -y; \

yum install -y sudo \

java-1.8.0-openjdk-devel; \

yum clean all;

RUN mkdir /docker-entrypoint-initdb.d

RUN useradd cubrid; \

sed 102s/#\ %wheel/%wheel/g -i /etc/sudoers; \

sed s/wheel:x:10:/wheel:x:10:cubrid/g -i /etc/group; \

sed -e '61 i\cubrid\t\t soft\t nofile\t\t 65536 \

cubrid\t\t hard\t nofile\t\t 65536 \

cubrid\t\t soft\t core\t\t 0 \

cubrid\t\t hard\t core\t\t 0\n' -i /etc/security/limits.conf; \

echo -e "\ncubrid soft nproc 16384\ncubrid hard nproc 16384" >> /etc/security/limits.d/20-nproc.conf

RUN curl -o /home/cubrid/CUBRID-$CUBRID_BUILD_VERSION-Linux.x86_64.tar.gz -O http://ftp.cubrid.org/CUBRID_Engine/$CUBRID_VERSION/CUBRID-$CUBRID_BUILD_VERSION-Linux.x86_64.tar.gz > /dev/null 2>&1 \

&& tar -zxf /home/cubrid/CUBRID-$CUBRID_BUILD_VERSION-Linux.x86_64.tar.gz -C /home/cubrid \

&& mkdir -p /home/cubrid/CUBRID/databases /home/cubrid/CUBRID/tmp /home/cubrid/CUBRID/var/CUBRID_SOCK

COPY cubrid.sh /home/cubrid/

RUN echo ''; \

echo 'umask 077' >> /home/cubrid/.bash_profile; \

echo ''; \

echo '. /home/cubrid/cubrid.sh' >> /home/cubrid/.bash_profile; \

chown -R cubrid:cubrid /home/cubrid

COPY docker-entrypoint.sh /usr/local/bin/

RUN chmod +x /usr/local/bin/docker-entrypoint.sh; \

ln -s /usr/local/bin/docker-entrypoint.sh /entrypoint.sh

VOLUME /home/cubrid/CUBRID/databases

EXPOSE 1523 8001 30000 33000

ENTRYPOINT ["docker-entrypoint.sh"]

8-2. cubrid.sh

export CUBRID=/home/cubrid/CUBRID

export CUBRID_DATABASES=$CUBRID/databases

if [ ! -z $LD_LIBRARY_PATH ]; then

export LD_LIBRARY_PATH=$CUBRID/lib:$LD_LIBRARY_PATH

else

export LD_LIBRARY_PATH=$CUBRID/lib

fi

export SHLIB_PATH=$LD_LIBRARY_PATH

export LIBPATH=$LD_LIBRARY_PATH

export PATH=$CUBRID/bin:$PATH

export TMPDIR=$CUBRID/tmp

export CUBRID_TMP=$CUBRID/var/CUBRID_SOCK

export JAVA_HOME=/usr/lib/jvm/java

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.

export LD_LIBRARY_PATH=$JAVA_HOME/jre/lib/amd64:$JAVA_HOME/jre/lib/amd64/server:$LD_LIBRARY_PATH

8-3. docker-entrypoint.sh

#!/bin/bash

set -eo pipefail

shopt -s nullglob

# 데이터베이스 기본 문자셋을 설정합니다.

# '$CUBRID_CHARSET' 환경변수를 설정하지 않으면 'ko_KR.utf8'을 기본 문자셋으로 설정합니다.

if [[ -z "$CUBRID_CHARSET" ]]; then

CUBRID_CHARSET='ko_KR.utf8'

fi

# 컨테이너 시작 시 생성할 데이터베이스 이름을 설정합니다.

# '$CUBRID_DATABASE' 환경변수를 설정하지 않으면 'demodb'를 기본 데이터베이스로 설정합니다.

if [[ -z "$CUBRID_DATABASE" ]]; then

CUBRID_DATABASE='demodb'

fi

# 데이터베이스에서 사용할 사용자 계정의 이름을 설정합니다.

# '$CUBRID_USER' 환경변수를 설정하지 않은면 'dba'를 기본 사용자로 설정합니다.

if [[ -z "$CUBRID_USER" ]]; then

CUBRID_USER='dba'

fi

# 데이터베이스에서 사용할 'dba' 계정의 비밀번호와 사용자 계정의 비밀번호를 설정합니다.

# '$CUBRID_DBA_PASSWORD', '$CUBRID_PASSWORD' 환경변수를 확인하여 각각 설정합니다.

# 두 환경변수 중에 하나만 설정되어 있으면 두 환경변수 모두 동일한 값으로 설정합니다.

# 두 환경변수 모두 설정되어 있지 않으면 '$CUBRID_PASSWORD_EMPTY' 환경변수 값을 1로 설정합니다.

if [[ ! -z "$CUBRID_DBA_PASSWORD" || -z "$CUBRID_PASSWORD" ]]; then

CUBRID_PASSWORD="$CUBRID_DBA_PASSWORD"

elif [[ -z "$CUBRID_DBA_PASSWORD" || ! -z "$CUBRID_PASSWORD" ]]; then

CUBRID_DBA_PASSWORD="$CUBRID_PASSWORD"

elif [[ -z "$CUBRID_DBA_PASSWORD" || -z "$CUBRID_PASSWORD" ]]; then

CUBRID_PASSWORD_EMPTY=1

fi

# 현재 CUBRID를 관리할 수 있는 계정으로 접속되어 있는지 확인합니다.

if [[ "$(id -un)" = 'root' ]]; then

su - cubrid -c "mkdir -p \$CUBRID_DATABASES/$CUBRID_DATABASE"

elif [[ "$(id -un)" = 'cubrid' ]]; then

. /home/cubrid/cubrid.sh

mkdir -p "$CUBRID_DATABASES"/"$CUBRID_DATABASE"

else

echo 'ERROR: Current account is not vaild.'; >&2

echo "Account : $(id -un)" >&2

exit 1

fi

# 컨테이너 시작 시 '$CUBRID_DATABASE' 환경변수에 설정된 이름으로 데이터베이스를 생성합니다.

su - cubrid -c "mkdir -p \$CUBRID_DATABASES/$CUBRID_DATABASE && cubrid createdb -F \$CUBRID_DATABASES/$CUBRID_DATABASE $CUBRID_DATABASE $CUBRID_CHARSET"

su - cubrid -c "sed s/#server=foo,bar/server=$CUBRID_DATABASE/g -i \$CUBRID/conf/cubrid.conf"

# 기본 사용자 계정이 'dba'기 아니면 '$CUBRID_USER' 환경변수 값으로 사용자 계정을 생성합니다.

if [[ ! "$CUBRID_USER" = 'dba' ]]; then

su - cubrid -c "csql -u dba $CUBRID_DATABASE -S -c \"create user $CUBRID_USER\""

fi

# 기본 데이터베이스가 'demodb'이면 '$CUBRID_USER' 환경변수로 설정한 계정에 DEMO 데이터를 생성합니다.

if [[ "$CUBRID_DATABASE" = 'demodb' ]]; then

su - cubrid -c "cubrid loaddb -u $CUBRID_USER -s \$CUBRID/demo/demodb_schema -d \$CUBRID/demo/demodb_objects -v $CUBRID_DATABASE"

fi

# '$CUBRID_PASSWORD_EMPTY' 환경변수 값이 1이 아니면 '$CUBRID_DBA_PASSWORD' 환경변수 값으로 DBA 계정의 비밀번호를 설정합니다.

if [[ ! "$CUBRID_PASSWORD_EMPTY" = 1 ]]; then

su - cubrid -c "csql -u dba $CUBRID_DATABASE -S -c \"alter user dba password '$CUBRID_DBA_PASSWORD'\""

fi

# '$CUBRID_PASSWORD_EMPTY' 환경변수 값이 1이 아니면 '$CUBRID_PASSWORD' 환경변수 값으로 사용자 계정의 비밀번호를 설정합니다.

if [[ ! "$CUBRID_PASSWORD_EMPTY" = 1 ]]; then

su - cubrid -c "csql -u dba -p '$CUBRID_DBA_PASSWORD' $CUBRID_DATABASE -S -c \"alter user $CUBRID_USER password '$CUBRID_PASSWORD'\""

fi

# '/docker-entrypoint-initdb.d' 디렉터리에 있는 '*.sql' 파일들을 csql 유틸리티로 실행합니다.

echo

for f in /docker-entrypoint-initdb.d/*; do

case "$f" in

*.sql) echo "$0: running $f"; su - cubrid -c "csql -u $CUBRID_USER -p $CUBRID_PASSWORD $CUBRID_DATABASE -S -i \"$f\""; echo ;;

*) echo "$0: ignoring $f" ;;

esac

echo

done

# 'dba' 계정의 비밀번호와 사용자 계정의 비밀번호가 설정되어 있는 '$CUBRID_DBA_PASSWORD', '$CUBRID_PASSWORD' 두 환경변수를 제거합니다.

unset CUBRID_DBA_PASSWORD

unset CUBRID_PASSWORD

echo

echo 'CUBRID init process complete. Ready for start up.'

echo

su - cubrid -c "cubrid service start"

tail -f /dev/null

8-4. build.sh

docker build --rm -t cubridkr/cubrid-test:10.1.2.7694 .

8-5. 빌드하여 Docker 이미지 생성

# sh build.sh

9. Docker Hub에 CUBRID 컨테이너 이미지 올리기

Docker Hub에 Docker 이미지를 올리기 위해서는 Docker Hub 계정과 Repository를 먼저 생성해야 합니다. 하지만 이 부분에 대한 내용은 간단하므로 생략하고 Docker Hub Repository까지 생성되어 있는 상태에서 Docker 이미지를 올리는 과정만 소개하겠습니다.

9-1. Docker Hub 로그인

# docker login

9-2. Docker Hub에 Docker 이미지 올리기

# docker push cubridkr/cubrid-test:10.1.2.7694

9-3. Docker Hub 확인

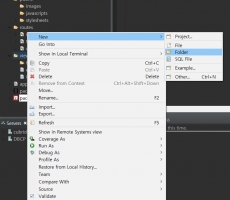

10. Kubernetes 환경에 CUBRID 컨테이너 배포

Kubernetes YAML 형식을 작성하여 Kubernetes 환경 Docker 컨테이너를 배포할 수 있습니다.

# cat << EOF | kubectl create -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: cubrid

spec:

selector:

matchLabels:

app: cubrid

replicas: 1

template:

metadata:

labels:

app: cubrid

spec:

containers:

- name: cubrid

image: cubridkr/cubrid-test:10.1.2.7694

imagePullPolicy: Always

ports:

- name: manager

containerPort: 8001

- name: queryeditor

containerPort: 30000

- name: broker1

containerPort: 33000

---

apiVersion: v1

kind: Service

metadata:

name: cubrid

spec:

type: NodePort

ports:

- name: manager

port: 8001

- name: queryeditor

port: 30000

- name: broker1

port: 33000

selector:

app: cubrid

EOF

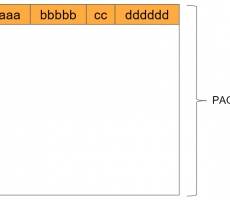

10-1. Dashboard에 접속하여 CUBRID 컨테이너 배포

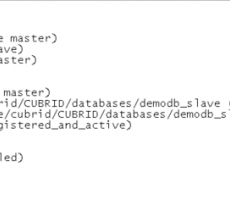

10-2. 접속정보 확인

# kubectl get service cubrid

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

cubrid NodePort 10.97.153.24 <none> 8001:31965/TCP,30000:30022/TCP,33000:30035/TCP 51s

10-3. CUBRID Manager 접속 확인

좋은 내용 감사합니다. 이것을 바탕으로 k8s 에 cubrid 배포 성공하였습니다.

저는 11.2 버전을 배포하였는데 배포 중에

cubrid: error while loading shared libraries: libcascci.so.11.1: cannot open shared object file: No such file or directory

이런 에러가 생겼었고 문의를 통해 도움을 받을 수 있었습니다.

비슷한 현상을 겪으시는 분들은 아래 게시물을 참고하시면 좋을 것 같습니다.

https://www.cubrid.com/qna/3838464